Guías éticas para el uso de la inteligencia artificial en el periodismo

- Patrícia

- 13 abr 2023

- 18 Min. de lectura

Actualizado: 5 sept 2025

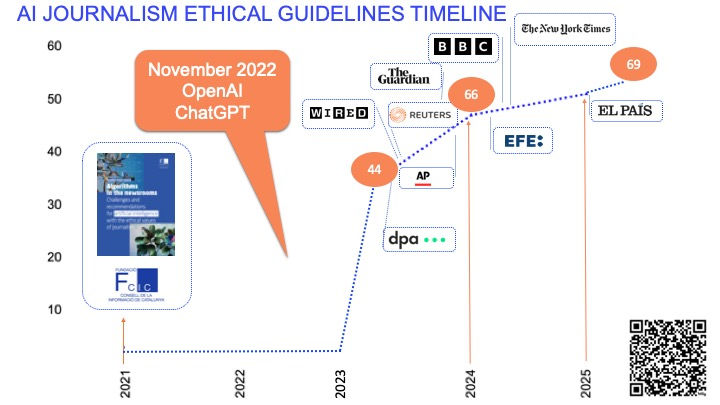

Desde que en 2021 el Consell de la Informació de Catalunya publicó el informe y el decálogo para el uso ético de la inteligencia artificial en los medios de comunicación han ido apareciendo guías sobre ética, IA y periodismo que han desarrollado principalmente en medios y agencias. La mayoría, en Europa, y todas de las cuales se tiene coonstancia de fecha, a partir de 2023, tras de la irrupción de ChatGPT. Sin duda, la IA generativa ejerció un claro impulso en la publicación de códigos de conducta.

En este artículo describiremos algunas de las más relevantes y las examinaremos. Mäs adelante, exponemos los patrones que identificamos entre las guías éticas.

Además, al final del post, encontraréis una tabla con más guías éticas de todo el mundo que seguimos añadiendo. En total, más de 70 guías éticas enlazadas publicadas en las zonas geográficas que muestra el mapa:

Iremos actualizando la tabla a medida que vayan saliendo. Si conocéis alguna que no esté y me lo decís en comentarios o por aquí la incorporaremos.

Wired (2023)

Se centran en la IA generativa y en este artículo explican sus reglas. Los puntos básicos: no van a usar IA para generar texto ni para editarlo, pero dejan claro también que es posible que la usen para sugerir títulos o copies para las redes sociales. También se permiten emplearla para generar ideas de posibles temas, así como para investigación o como herramienta analítica. "No queremos que nuestros reporteros confíen en estas herramientas más de lo que les permitiríamos confiar en la información limitada de Wikipedia", aseguran.

Sobre las herramientas de generación de imágenes:

Solo publicarán aquellas imágenes que hayan sido generadas por artistas en las que el peso del trabajo creativo del artista sea superior al de la aportación de la herramienta. Se prestará atención a que no imite trabajos existentes o infrinja copyright.

No se sustituirán imágenes de stock por las generadas con IA porque muchos profesionales de la fotografía se ganan la vida vendiendo imágenes a archivos de este tipo. No lo harán al menos hasta que las empresas de IA compensen a los creadores de las obras con las que su herramienta se ha entrenado.

Es posible que usen IA generativa de imágenes para obtener ideas en procesos de brainstorming.

------

Si estáis pensando en elaborar vuestro propio código de conducta para una adopción responsable de la IA, el decálogo de recomendaciones que encontraréis en la página 34 puede ser una buena herramienta para empezar.

------

Springer-Nature (2023)

En Springer-Nature también focalizan en los grandes modelos lingüísticos (tipo GPT) y defienden que "los editores deben reconocer sus usos legítimos y establecer pautas claras para evitar el abuso".

De momento han establecido dos normas básicas. La primera, una IA no puede firmar. La segunda, cualquier uso de IA debe ser explicitado:

1- No aceptará ninguna herramienta como autor acreditado en un trabajo de investigación. Esto se debe a que cualquier atribución de autoría conlleva responsabilidad por el trabajo, y las herramientas de IA no pueden asumir tal responsabilidad.

2- Los investigadores que utilizan herramientas tipo grandes modelos lingüísticos deben documentar su uso en las secciones de métodos o agradecimientos. Si un artículo no incluye estas secciones, se puede usar la introducción u otra sección apropiada para explicarlo.

Heidi News (2023)

Aseguran que no quieren renunciar a los avances tecnológicos, pero consideran necesario establecer unas pautas para el uso de la IA basadas en "la ética que rige" su actividad, y "sobre todo la relación de confianza" con sus lectores. Una vez más, en este medio francés se centran en la IA generativa:

Principios generales:

Puede utilizar IA para facilitar o mejorar los procesos, pero la inteligencia humana seguirá estando en el centro de toda su producción editorial. Ningún contenido será publicado sin previa supervisión humana.

Apoya el trabajo de periodistas, autores, fotógrafos e ilustradores. Aseguran que no pretenden sustituirlos por máquinas.

Textos sintéticos

Todo artículo publicado se firmará por uno o más periodistas, quienes permanecen como garantes de la veracidad y pertinencia de la información que contiene.

La inteligencia artificial puede ayudar al trabajo de los periodistas para refinar los datos en bruto de la misma manera que un software como Excel, y también puede servir como complemento para escribir artículos, y la equipara a un diccionario de sinónimos en línea o correctores ortográficos automáticos.

Considera a las IA como herramientas, pero de ninguna manera fuentes de información.

Imágenes sintéticas

Se limitará a utilizar las imágenes sintéticas con fines ilustrativos, y no informativos, para no inducir a confusión sobre hechos del mundo real.

No publicará una imagen sintética que pueda pasar por fotografía, salvo con fines educativos, cuando la imagen en cuestión ya sea pública.

Cualquier imagen sintética publicada irá acompañada de una marca visible que explique su origen. La leyenda mencionará el modelo de IA utilizado y la instrucción principal que se le dio.

Los grandes temas (investigaciones, reportajes, etc.) no se ilustrarán con imágenes sintéticas, a menos que estas creaciones hayan sido diseñadas por un artista que utilice IA bajo su propia responsabilidad.

DPA (2023)

La agencia de noticias alemana DPA basará el uso ético de la IA en 5 reglas. Para elaborarlas parece que ha considerado las directrices para una IA fiable de la UE:

1- DPA utiliza la IA para diversos fines y está abierta a un mayor uso de la IA. La IA ayudará a hacer nuestro trabajo mejor y más rápido, siempre en interés de nuestros clientes y nuestros productos.

2- Solo usa IA bajo supervisión humana. La decisión final sobre el uso de productos basados en IA la toma un ser humano. Respetamos la autonomía humana y la primacía de las elecciones humanas.

3- Solo utiliza IA legítima que cumple con la ley aplicable y las disposiciones legales y que respeta sus principios éticos, como la autonomía humana, la equidad y los valores democráticos.

4- Utiliza IA que es técnicamente robusta y segura para minimizar el riesgo de errores y uso indebido. Cuando el contenido es generado exclusivamente por IA, lo hace, dice, de forma transparente y explicable. Siempre hay una persona responsable de todo el contenido generado con IA.

5- Alienta a todos los empleados a ser abiertos y curiosos sobre las posibilidades de la IA, probar herramientas y hacer sugerencias para usar en los flujos de trabajo. La transparencia, la apertura y la documentación son cruciales.

BBC (2023-24)

La BBC publicó hace un tiempo sus seis principios rectores y una lista de verificación de autoauditoría para equipos de Aprendizaje Automático (ingenieros, científicos de datos, product managers, etc.). Está basado en valores de servicio público y diseñado para ser práctico. Espera que su marco "sea una contribución útil para el desarrollo de IA y ML responsables y confiables". La guía se refleja en este proceso:

LA BBC y la IA generativa

Enfocada de forma específica a la IA generativa, la BBC publicó en octubre de 2023 los tres principios rectores con los que quiere guiar el uso de la IA. Todos coinciden con algunas de las principales recomendaciones del informe del CIC:

1- Actuar en el mejor interés del público y poner la IA al servicio de la misión del periodismo.

2- Potenciar el factor humano, priorizando el talento y la creatividad.

3- Transparencia y responsabilidad.

Más adelante, en febrero de 2024, compartió 3 marcos de trabajo que nacen de estos principios bajo los cuales desarrolla proyectos interesantes. Vale la pena compartirlos aquí porque son buenos ejemplos de uso de la IA al servicio de la misión del periodismo:

1- Maximizar el valor del contenido existente

2- Proporcionar nuevas experiencias a la audiencia

3- Optimizar procesos "Hacer que la forma en que hacemos las cosas sea más rápida y sencilla".

También detalla algunos casos:

1- Maximizar el valor del contenido existente

1) Traducir a varios idiomas.

2) Reformatear contenido existente para hacerlo más atractivo.

2- Proporcionar nuevas experiencias a la audiencia

1) Un asistente de la BBC: chatbot para ofrecer aprendizaje interactivo y personalizado.

2) Marketing más personalizado

Crear textos, imágenes y videos más personalizados en el contenido y los servicios de marketing.

3- Optimizar procesos:

1) Apoyar a los periodistas

Explorar cómo equipar a los periodistas con herramientas de IA generativa que les ayuden a trabajar más rápido. Por ejemplo, un “ayudante de titulares” (que podría ofrecer a los periodistas opciones de titulares para elegir o la posibilidad de resumir un artículo) para vincularlos a otros lugares.

2) Simplificar la forma en que organizan y etiquetan el contenido.

Explorar cómo la IA generativa puede ayudar a los equipos a encontrar contenido dentro de los programas a través de prácticas como un mejor etiquetado. Esto les ayudará a crear nuevas formas de contenido más rápidamente, por ejemplo. Identificar un clip o colección de determinados momentos dentro de un programa o programas.

Guia ética para el uso de la IA

También en febrero de 2024 actualizó su guía ética para el uso de la IA. En ella, especifica que el uso de la IA debe estar guiado por su libro de estilo y sus valores editoriales, en especial, por el rigor, la imparcialidad, justicia y privacidad.

En cuanto a las cuestiones editoriales, en primer lugar, que cualquier uso de la IA debe estar justificado por la tarea que se le va a encargar; en segundo lugar, especifica que siempre debe existir una figura responsable editorial del desarrollo del sistema; en tercer lugar, indica que se tiene que informar a la audiencia siempre que intervenga la IA. Además, debe concretar por qué y cómo ha operado la IA en el contenido.

En su guía destaca la necesidad de prestar especial atención a los sesgos, a las "alucinaciones", y al riesgo de plagio que conlleva el uso de determinadas aplicaciones, de lo que se deduce que acepta el uso de herramientas más extendidas de IA generativa. Sin embargo, consciente de estos riesgos, remarca de nuevo la necesidad de supervisión humana y de la figura de responsable editorial por cada uso de la IA. Asimismo, expresa su posicionamiento ante el dilema ético que implica usar herramientas que se han entrenado con contenidos sujetos a derechos de autor. En este sentido, expresa que cualquier uso de la IA debe considerar los derechos de los creadores a la vez que "debe permitir el uso creativo de nuevas formas de expresión".

La guía también dedica un apartado a recordar los riesgos "no editoriales" del uso de la IA, como por ejemplo las cuestiones legales, protección de datos, etc. Para tratar este grupo de supuestos externos a la guía editorial, la BBC cuenta con una comisión multidisciplinaria, denominada AI Risk Advisory Group (AIRA). Este grupo incluye figuras expertas legales, de protección de datos, finanzas, comercial y editoriales que evalúa los casos y hace recomendaciones desde la doble perspectiva editorial y no editorial.

La guía de recomendaciones para el uso de la IA en la BBC adopta el marco de las 3 fases de producción, y hace recomendaciones específicas para cada fase, que resumimos a continuación:

Creación de contenidos

En esta fase la BBC explicita que no admite la publicación de contenido generado por IA. Aún así considera varias excepciones. En primer lugar, acepta el uso de la IA generativa para la creación de gráficos. También puede llegar a admitir otros usos, tanto en texto como en imagen, siempre que no afecte al enfoque editorial de la información o distorsione su significado. Un ejemplo de lo que la BBC considera un uso inocuo seria la generación de voces sintéticas, siempre que no sean clonadas.

Producción de contenidos /investigación

En esta fase, la IA puede usarse para extraer y / o analizar información. Por un lado, la BBC no considera que exista riesgo alguno en el uso de la IA para las dinámicas de ideación y otras técnicas de creatividad. Por el otro, sí detecta la existencia de ciertos riesgos en el uso de la IA para analizar información. Ante la posibilidad de que la aplicación proporcione información "editorialmente inapropiada" , recomienda una "cuidadosa supervisión editorial humana".

Distribución

Los recomendadores y otras herramientas de personalización son consideradas "experiencias editoriales", por lo tanto deben contar con aprobación editorial y sus resultados deben estar alineados con sus valores editoriales, en especial con la imparcialidad, justicia y el derecho al honor.

Finalmente, la guía de la BBC especifica que también los contenidos externos deben ser supervisados editorialmente por sus equipos, de forma que estos también estén alineados con sus criterios editoriales.

The Guardian (2023)

Ha formado un equipo multidisciplinario para elaborar su propia guía ética, enfocada a la IA generativa. Los principios que rigen el uso de estas herramientas son:

1- Para el beneficio de los lectores:

siempre que contribuya positivamente a su periodismo original y con la aprobación específica de un editor senior. Serán transparentes sobre su uso.

2- Para el beneficio de su misión, personal y resto de la organización:

Orientada a la mejora de la calidad del producto y de la eficiencia de los procesos.

4- Con respeto hacia las personas/organizaciones creadoras:

Priorizarán herramientas respetuosas con los derechos de autor.

ANP (2023)

La agencia de noticias neerlandesa ANP. considera que la IA debe ser abordada por sus periodistas con actitud de “asombro, curiosidad, crítica y apertura”. “Depende de los editores si es relevante y útil si las aplicaciones de IA se utilizan en producciones editoriales o periodísticas. En pocas palabras, la IA es una herramienta, no un sustituto”.

Destaco algunos principios, que tienen que ver con la necesidad de supervisión de la IA y la necesaria asunción humana de responsabilidad:

Cuando la IA juega un papel en el proceso editorial, una persona siempre debe hacer la verificación final. ANP describe la cadena de producción editorial como persona > máquina > persona. “Pensar y decidir comienza y termina con la persona. Por lo tanto, no utilizamos contenido informático o producido por IA, ni siquiera como material de origen, sin que un ser humano verifique esta información”, dicen.

La IA solo se podrá usar con la autorización de los supervisores y jefas de redacción. Pondrá especial cuidado en evitar potenciales errores (alucinaciones o sesgos).

Reuters (2023)

La responsable de edición, Alessandra Galloni, y el editor responsable de ética, Alix Freedman, enviaron una comunicación al personal de la agencia con varios puntos relacionados con el uso de la IA:

En primer lugar, Reuters considera la tecnología de IA, incluidos los modelos basados en texto generativos como ChatGPT, como un avance que ofrece el potencial de mejorar su periodismo y empoderar a sus periodistas. Reuters explica que, desde su fundación, ha adoptado nuevas tecnologías para ofrecer información "desde las palomas mensajeras hasta el telégrafo e Internet". Más recientemente, ha utilizado sistemas automatizados para informar sobre temas de economía, y esto ha resultado fundamental para poder dar servicio a la velocidad que exigen sus clientes, por tanto, la automatización del contenido no es ninguna novedad para Reuters.

A continuación reproducimos el resto de puntos de la guía:

En segundo lugar, los periodistas y editores de Reuters supervisarán el contenido creado con IA. Una historia de Reuters es una historia de Reuters, independientemente de quien la produce o cómo se genera, y se aplican sus estándares y ética editorial. Si el nombre de un periodista aparece en una historia, él es responsable de asegurarse de que la historia cumple estos estándares; si una historia se publica de forma totalmente autónoma, será porque los periodistas de Reuters han determinado que la tecnología subyacente puede ofrecer la calidad y los estándares que necesitan.

En tercer lugar, Reuters comunicará a la audiencia sobre el propio uso de estas herramientas. La transparencia es una parte esencial de su ethos, explica. Dará a sus lectores y clientes la mayor información posible sobre el origen de una noticia, desde la especificidad de la fuente hasta los métodos utilizados para crearla o publicarla. Esto no significa que vayan a divulgar todos los pasos del proceso editorial. Pero cuando el uso de una herramienta de IA concreta sea importante para el resultado, serán transparentes.

Por último, explorar las posibilidades que ofrece la nueva generación de herramientas no es opcional, aunque todavía están examinando cómo hacer un uso más adecuado. Los principios de confianza exigen "no escatimar esfuerzos por ampliar, desarrollar y adaptar" las noticias. También exigen que proporcionen noticias "fiables". Dada la proliferación de contenido generado por IA, deben mantenerse vigilantes para que las fuentes del contenido sean reales. Su mantra: Sé escéptico y verifica.

En resumen, Reuters aprovechará la IA para apoyar su periodismo cuando estén seguros de que los resultados cumplen con sus estándares de calidad y precisión, y con una supervisión rigurosa por parte de los editores de las redacciones.

Financial Times (2023)

"Nuestro periodismo seguirá siendo reportado, escrito y editado por humanos que son los mejores en sus campos", éste es el mensaje que encabeza la carta que el editor del FT envió al equipo. Las indicaciones están orientadas, como en la mayoría de los casos, a los usos de la IA generativa.

Tras explicar qué es la IA generativa, considera las oportunidades de la tecnología: mejorar procesos y productividad. Entonces, menciona los riesgos: ausencia de rigor, hechos fabricados, sesgos...

Se muestra convencido de que el periodismo se hará aún más necesario en este contexto:

"En un momento en que la desinformación se puede generar y difundir rápidamente y la confianza en los medios de comunicación en general ha disminuido, en el FT tenemos una mayor responsabilidad de ser transparentes, informar sobre los hechos y buscar la verdad. Es por eso que el periodismo del FT en la nueva era de la IA seguirá siendo informado y escrito por humanos que son los mejores en sus campos y que se dedican a informar y analizar el mundo tal y como es, de forma precisa y justa."

Al mismo tiempo, explica que explorarán nuevos usos de la IA para hacer periodismo, de forma responsable, puntualiza: "como ha demostrado la historia reciente, la emoción debe ir acompañada de prudencia ante el riesgo de desinformación y la corrupción de la verdad. El FT seguirá comprometido con su misión fundamental y mantendrá informados a los lectores a medida que la propia IA generativa y nuestro pensamiento evolucionan."

USA Today (2023)

En este caso, el editor responsable debe aprobar el uso de la IA en la pieza informativa, y para hacerlo se basa en el propósito, es decir, si el uso de la IA tiene sentido en su misión. Una vez aprobado, los principios en los que debe basarse el uso de la IA son:

Transparencia y rigor: contrastar toda información generada con IA. Ser transparentes, comunicar cuándo se ha usado IA y verificar cualquier contenido creado con IA.

Criterio editorial: asegurarse que los valores del medio están presentes en cualquier información.

Uso permitido: Asegurarse que el uso de la IA es ético y legal.

IA generativa (imágenes): limitar su uso. En ningún caso se usarán para cubrir contenido de última hora. Las imágenes sintéticas deberán estar muy claramente marcadas para no dejar lugar a dudas de que no representan hechos reales.

Privacidad: Asegurarse de que no viola la privacidad de los usuarios.

Sesgos: tener la seguridad de que el contenido no es discriminatorio.

Seguridad: evitar cualquier tipo de error o falta de rigor en el contenido sintético.

Diversidad e inclusión: el contenido debe reflejar la diversidad de la audiencia.

Agencia EFE (2024)

En su Nuevo libro de estilo urgente, la agencia EFE decidió introducir un apartado sobre el tema en el que reclamó la necesidad de establecer principios claros para el uso de la IA que se adapten a su rápida evolución. EFE reconoce que determinadas aplicaciones de IA pueden resultar útiles como apoyo para los periodistas, aunque, dice, nunca deben suplir su labor. Destaca que es esencial actualizar y supervisar constantemente estas herramientas, dada su propensión a inexactitudes y falta de verificabilidad. Además, se debe identificar claramente cuando se utilicen, incluyendo una nota que indique su origen automático al final del texto. Un resumen de los puntos:

Solo una ayuda. Los sistemas de inteligencia artificial pueden, en algunos casos, servir como ayuda al trabajo de los periodistas de EFE, nunca hacer periodismo; esa labor les corresponde a los periodistas.

Cuidado y actualización constante. La rapidez con la que evolucionan este tipo de herramientas aconseja una actualización constante de las normas al respecto. .

Supervisión siempre. Es fundamental revisar, comprobar y verificar cada una de las aportaciones que se tomen de las herramientas de IA. No será necesario citar el uso de herramientas como las de traducción o transcripción (de la misma forma que no se citan otro tipo de herramientas que ayudan a la elaboración de información).

Imágenes. EFE no empleará este tipo de sistemas de creación de imágenes para ilustrar noticias de actualidad. Solo las considera aceptables si sirven "para ilustrar descubrimientos que no pueden tener una foto: cómo sería un animal reconstruido a partir de un fósil, cómo se vería el espacio desde un lugar inaccesible..." En todo caso, si se emplean recreaciones de ese tipo, tanto propias como cedidas, se señalarán "de forma clara e inequívoca en el pie de foto o el texto que acompañe al vídeo la naturaleza de las mismas".

Contenido generado automáticamente a partir de fuentes identificadas.

Las informaciones creadas de ese modo deben identificar la fuente en el texto, como todas las demás, e incluir al final una nota aclaratoria: “Esta información se ha generado de forma automática a partir de los datos de...”.

El País (2025)

Este diario ha adaptado recientemente el libro de estilo para incluir una guía de uso de la IA. A través de este artículo de la defensora del lector, sabemos que los principales criterios que emplea son la supervisión humana de cualquier uso de la IA, la figura del redactor responsable de su uso y la transparencia a la hora de comunicar al lector cuando esta tecnología interviene.

Este diario destaca que se debe prestar especial atención a cualquier uso de la IA que pueda modificar el significado de un mensaje, "que puedan confundirse con la realidad, que puedan inducir a error, desinformar o violar la privacidad y el derecho a la propia imagen".

Referente al caso concreto de los ilustradores que colaboran con El País, el diario acepta que utilicen la IA siempre que lo comuniquen y que, según su director de Arte, Diego Areso "los elementos creados por inteligencia artificial deben ser un ingrediente secundario, sometido al concepto general de la ilustración y que no disminuya la calidad del material publicado".

Además, todas las personas trabajadoras tienen la obligación de informar sobre las herramientas de IA que utilicen para poder valorar si pueden poner en riesgo la seguridad de la infraestructura digital del grupo.**

El anexo del libro de estilo, del cual el diario aún no ha informado con detalle, se basa en la premisa de que la IA estará al servicio de los profesionales para mejorar la calidad del trabajo periodístico y no para reemplazarlo.

The New York Times (2024)

El New York Times reconoce que la inteligencia artificial representa un cambio fundamental en el trabajo del conocimiento. Aunque ve riesgos en su uso, considera que prohibirla no es una solución viable, ya que las restricciones pueden fomentar el uso no regulado de herramientas de IA dentro de la redacción. En este contexto, ha optado por establecer directrices claras para su implementación.

Al mismo tiempo, mantiene una postura crítica respecto a los modelos de IA generativa, como demuestra su demanda contra OpenAI, pero busca aprovechar su potencial dentro de límites bien definidos.

Usos permitidos de la IA

- Generación de titulares optimizados para SEO

- Resumen de artículos

- Lluvia de ideas y apoyo en la edición

- Investigación

Usos prohibidos de la IA

- Redacción o reescritura significativa de artículos

- Subida de material protegido por derechos de autor

- Evasión de muros de pago

- Uso de IA generativa para crear imágenes o vídeos, salvo en reportajes sobre la tecnología en sí

Herramientas

El NYTha definido un conjunto de herramientas autorizadas para su equipo, que incluyen Google Vertex AI, GitHub Copilot y una versión restringida de OpenAI API (solo con aprobación legal). Además, ha desarrollado su propia herramienta de resumen, llamada Echo, para facilitar ciertas tareas sin comprometer el control editorial.

En mayo de 2024, publicó sus principios para el uso de la IA generativa. Se trata de unos puntos muy generales. Me ha llamado la atención la referencia explícita a la utilidad de los principios del periodismo para gobernar a la IA. El ejercicio que hicimos para el informe del CIC, fue precisamente analizar herramientas y aplicaciones de IA i confrontarlas con los grandes valores éticos del periodismo. El decálogo de recomendaciones para el uso ético de la IA nació de ese ejercicio. Los 3 principios que regirán el uso de la IA generativa en el caso del New York times:

Como herramienta al servicio de su misión: La IA generativa puede potenciar sus capacidades periodísticas, ayudándoles a descubrir la verdad y a hacer que The Times sea más accesible. Aunque no es una solución mágica, es una herramienta poderosa.

Guía y supervisión humana: La experiencia y el criterio de sus periodistas son esenciales. La IA generativa puede asistir, pero el trabajo siempre será gestionado y supervisado por periodistas, asegurando responsabilidad y precisión.

De forma transparente y ética: Los principios del periodismo se aplican igualmente a la IA. Informarán a los lectores sobre el uso de IA y cómo mitigan riesgos como el sesgo y la inexactitud, manteniendo sus altos estándares y ética periodística.

Reporteros sin Fronteras (2023)

RSF también ha presentado recientemente la que ha denominado 'Carta de París' sobre IA y periodismo que se resume en los siguientes puntos:

La ética debe regir las decisiones tecnológicas en el seno de los medios.

El criterio humano debe seguir siendo central en las decisiones editoriales.

Los medios deben ayudar a la sociedad a discernir con confianza entre los contenidos auténticos y los sintéticos.

Los medios deben implicarse en la gobernanza mundial de la IA y defender la viabilidad del periodismo cuando negocien con empresas tecnológicas.

Patrones que podemos extraer del análisis

Tras examinar guías y recomendaciones se identifican algunos patrones sobre cuáles son los principios rectores predominantes de los medios de comunicación a la hora de adoptar la IA generativa. Observamos que los valores éticos de veracidad, responsabilidad y transparencia son probablemente los que tienen mayor peso a la hora de articular sus recomendaciones. Como principio general,el uso de la IA está condicionado al hecho de que éste sea adecuado para conseguir la misión del propio medio, que supone actuar en el mejor interés del público y la sociedad. La responsabilidad humana en el producto informativo es una de las directrices más presentes. La ética y los valores del periodismo tradicional siguen siendo fundamentales. Destacamos algunos puntos a continuación:

Transparencia y supervisión humana:

La mayoría de las recomendaciones destacan la importancia de la transparencia en el uso de IA, especificando claramente cuando se utiliza IA en la producción de contenido.

Se insiste en la supervisión humana como un requisito esencial para garantizar el rigor y evitar otro tipo de riesgos.

Responsabilidad y verificación:

La responsabilidad humana es un tema recurrente, con énfasis en que las herramientas de IA no pueden asumir responsabilidad en cuestiones de autoría.

La verificación humana resulta un paso esencial en el proceso editorial.

Limitaciones en el uso de IA generativa:

Hay precauciones sobre el uso de IA generativa para generar texto o imagen, con enfoques diversos: desde no usarla para generar o editar texto (Wired) hasta limitar su uso y especificar claramente cuándo se ha empleado (USA Today). Las posturas intermedias (BBC, El Pais) buscan el equilibrio entre el respeto por los creadores y una cierta libertad para usar-a si es en beneficio del productor final.

Derechos de Autor y otros asuntos legales

Se enfatiza la importancia de respetar los derechos de autor y no utilizar IA para generar contenido que pueda infringir derechos.

En cuanto a las imágenes generadas, se establecen pautas sobre su uso, marcado claro y limitaciones para evitar confusiones con hechos reales.

La mayoría de las pautas insisten en que el uso de IA debe cumplir con la legislación aplicable y seguir principios éticos, como la autonomía humana, la equidad y los valores democráticos.

Compromiso con la diversidad y la inclusión:

Aunque en menor medida, se apunta la importancia de que el contenido generado por IA refleje la diversidad de la audiencia y que no contenga sesgos discriminatorios.

Estos patrones reflejan un amplio consenso sobre el hecho de que los valores éticos del periodismo resultan una guía apropiada para asimilar las herramientas de IA en los procesos. En este sentido, las recomendaciones del informe del CIC, basadas en los valores de la ética periodística (veracidad, responsabilidad, justicia y libertad) resultan una guía apropiada para la adopción de la IA en los medios de comunicación.

Comentarios